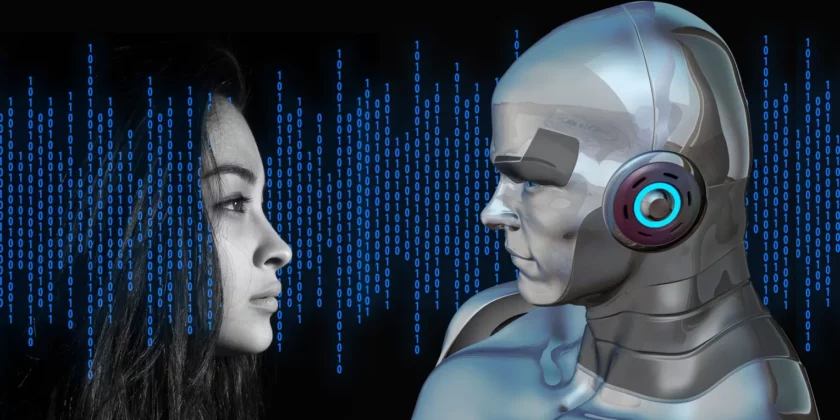

Naukowcy wkładają mózgi z ChatemGPT do ciał robotów

Na świecie istnieje cała masa robotów wykonujących określoną pracę. Są psy-roboty, ‘pracownicy’ magazynów, a nawet zmechanizowane pielęgniarki. Mimo że robią najróżniejsze rzeczy, działają w taki sam sposób i żaden z nich nawet nie zbliża się do poziomu elastyczności człowieka w radzeniu sobie z różnymi problemami i wyzwaniami. To twórcy definiują każde ich działanie, warunki wstępne oraz skutki. Roboty pracują w ściśle ograniczonych środowiskach, które pozwalają im postępować według równie ściśle ograniczonego scenariusza i powtarzać te same czynności. Mimo wielu cyklów prób i błędów oraz tysięcy linii kodu i tak powstanie robot, który nie będzie w stanie sobie poradzić, gdy napotka coś, czego jego programista nie przewidział.

Robotyka mimo wszystko jest dość ograniczona. Trzeba nauczyć robota mapy świata, a ten cały czas się zmienia.

W zasadzie projektowanie robotów od lat działa na takich samych zasadach, a twórcy z chęcią podłączyliby sprytny i praktyczny mózg do ciał robotów. Do tej pory było to jednak niemożliwe, a komputery były równie nieświadome, co same roboty.

W 2022 roku pojawił się jednak ChatGPT. Ten model językowy ma to, czego robotom brakuje. To dostęp do informacji niemal na każdy temat – od fizyki kwantowej, przez K-pop, po rozmrażanie filetu z łososia. Ale i roboty mają coś, czego nie ma sztuczna inteligencja – ciało, które może wchodzić w interakcję z otoczeniem. Wśród naukowców rozpoczął się więc wyścig na najlepszy sposób nauczenia dużego modelu językowego manipulowania ciałem robota.

Boston Dynamics już stworzyło psa-robota, który dzięki ChatowiGPT potrafi mówić, odpowiada na pytania i wykonuje proste instrukcje wydawane w zwykłym języku mówionym. Robot jest w stanie zrozumieć znaczenie słów i intencję, która za nimi swoi. Wie, że jeśli jeden użytkownik powie ‘cofnij się’, a drugi ‘wróć’, to mają na myśli to samo. Zamiast przeglądać arkusz kalkulacyjny z danymi z ostatniego patrolu robota, pracownik może po prostu zadać pytanie: ‘Jakie odczyty podczas ostatniego spaceru wykraczały poza normalny zakres?’. Nie oznacza to jednak, że w najbliższym czasie wszyscy będziemy mieli mówiące psy-roboty. Ten konkretny przykład faktycznie działa, ale tylko dlatego, że jest ograniczony do konkretnych warunków. Nikt nie będzie go prosił o aportowanie lub pytał o to, co zrobić z koprem włoskim zalegającym w lodówce.

Jednak robot powiązany z LLM (dużym modelem językowym) to specyficzne połączenie.

Nieograniczone możliwości językowe połączone są w tym przypadku z ciałem robota, który może zrobić tylko ułamek tego, co umie człowiek. Robot nie będzie w stanie delikatnie filetować łososia, jeśli ma tylko dwupalczasty chwytak do przenoszenia przedmiotów. Zapytany o to, jak to zrobić, owszem, prawdopodobnie odpowie bezbłędnie, ale ‘wszechwiedzący’ LLM zasugeruje działanie, którego robot nie będzie w stanie wykonać. Nawet inaczej padające na przedmiot światło sprawi, że robot będzie go widział już w inny sposób. Innym przykładem jest sytuacja, gdy mózg oparty o LLM każe robotowi nastawić minutnik w kuchence mikrofalowej na pięć minut. Jako że robot nie ma uszu, nie słyszy dźwięku timera, ale jego własny procesor mógł odmierzać czas. Podobnych różnic między tymi dwoma systemami jest znacznie więcej.

Tekst: MZ

112k

112k