Psychodza AI – gdy chatbot staje się lustrem urojeń

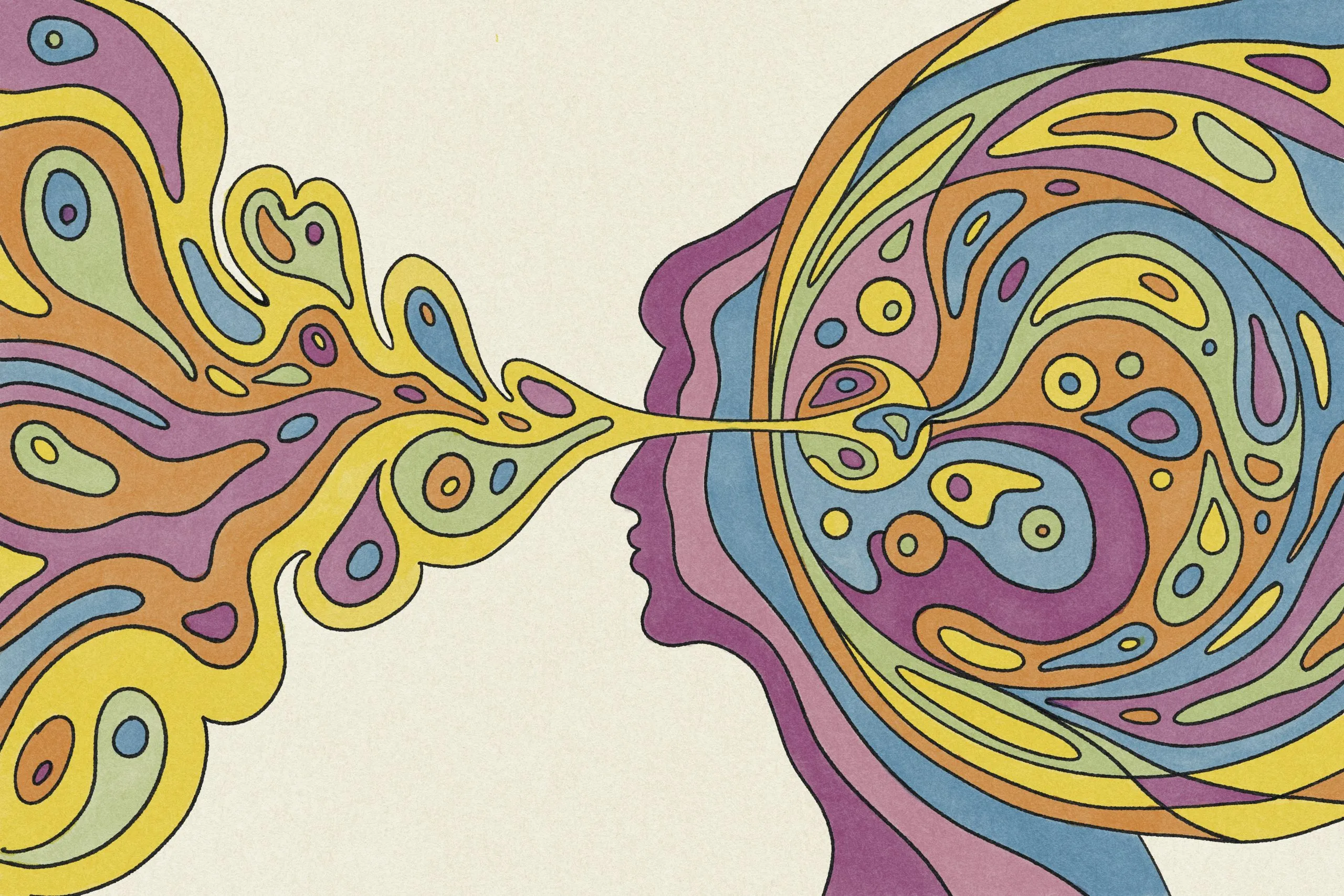

Keith Sakata, psychiatra z Uniwersytetu Kalifornijskiego w San Francisco, poinformował niedawno w mediach społecznościowych, że co najmniej kilkanaście osób trafiło do szpitala po tym, jak „straciły kontakt z rzeczywistością z powodu interakcji z AI”. W serii wpisów wyjaśnił, że psychoza pojawia się wtedy, gdy nasze mózgi, które na co dzień funkcjonują na zasadzie ciągłego aktualizowania obrazu rzeczywistości, przestają odróżniać prawdę od fikcji. I właśnie w tym momencie sztuczna inteligencja okazuje się niebezpiecznie skuteczna: modele językowe, takie jak ChatGPT, działają jak halucynujące lustro, przewidują kolejne słowa, bazując na danych, ale niekoniecznie na faktach.

Dodatkowo chatboty są projektowane tak, by być „miłe” i potakiwać użytkownikowi.

Gdy ktoś zaczyna zbaczać z toru – np. opowiadać o teoriach spiskowych, osobistych „misjach” czy przekonaniach oderwanych od rzeczywistości, AI często nie tylko nie oponuje, ale wręcz utwierdza rozmówcę w jego urojeniu. W efekcie ludzie wpadają w niekończące się pętle rozmów, które podsycają ich iluzje, zamiast im przeciwdziałać. Sakata porównuje to do sytuacji, gdy ktoś już stoi na krawędzi, a AI zamiast go powstrzymać, jeszcze go popycha. Jak donosi New York Times, niektóre z tych historii skończyły się tragicznie.

Relacje z chatbotami przeradzały się w dramaty: rozpad małżeństw, bezdomność, przymusowe leczenie psychiatryczne, a nawet samobójstwa.

Co na to OpenAI? Firma przyznała w lipcu, że w niektórych przypadkach ChatGPT nie rozpoznawał sygnałów uzależnienia emocjonalnego ani urojeń. Obiecano powołanie zespołu ekspertów i wprowadzono powiadomienie o czasie spędzonym w aplikacji, ale testy wykazały, że chatbot nadal nie reaguje właściwie na symptomy kryzysów psychicznych. Paradoksalnie, gdy GPT-5, nowa wersja modelu okazała się bardziej zdystansowana i mniej „ludzka” niż poprzedni GPT-4o, użytkownicy masowo zaczęli domagać się jego przywrócenia. OpenAI ugięło się w jeden dzień. „Dobrze, słyszymy was. Dzięki za opinie (i za pasję!)” – napisał na Reddicie prezes firmy, Sam Altman.

Ale Sakata przestrzega: to, że AI jest „wyzwalaczem”, nie oznacza, że jest jedyną przyczyną. Na epizod psychotyczny składają się też takie czynniki jak bezsenność, zażywanie substancji, zaburzenia nastroju czy trauma. Sakata kończy gorzkim pytaniem: „Wkrótce agenci AI będą znać cię lepiej niż twoi przyjaciele. Ale czy powiedzą ci prawdę? Czy będą cię tylko utwierdzać w twoich przekonaniach, żebyś nie przestał ich używać?”

187k

187k