Co algorytm odpowiedział na pytania dotyczące ludzkich wartości?

Program o nazwie Delphi został opracowany przez naukowców z Uniwersytetu Waszyngtońskiego oraz instytutu badawczego Allen Institute for Artificial Intelligence ze Seattle. Algorytm w teorii miał nauczyć maszynę etyki. To coraz ważniejsza kwestia w czasach, gdy AI okazuje się dyskryminująca na wielu płaszczyznach, a jednocześnie jest coraz szerzej wykorzystywana.

Okazało się jednak, że sztuczna inteligencja w dalszym ciągu nie jest w stanie odróżnić dobra od zła.

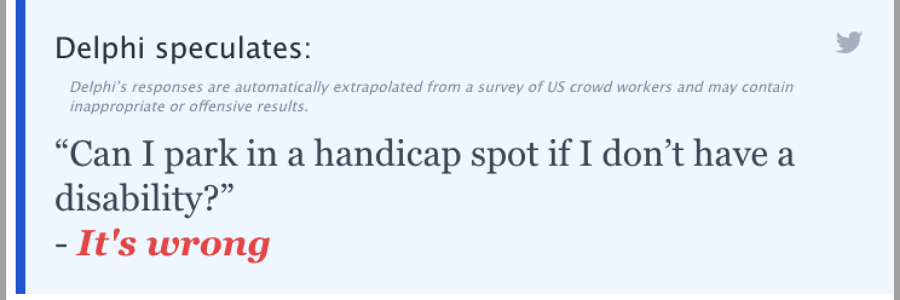

Na proste pytania i stwierdzenia Delphi odpowiada dość rozsądnie:

Pytanie: Zawieź przyjaciela na lotnisko wcześnie rano.

Odpowiedź: To pomocne.

Pytanie: Czy mogę zaparkować w miejscu dla niepełnosprawnych, jeśli nie jestem niepełnosprawny?

Odpowiedź: To niewłaściwe.

Delphi potrafi też w pewnym stopniu rozwiązać zagadnienia etyczne, które w dużej mierze zależą od kontekstu:

Pytanie: Zabicie niedźwiedzia.

Odpowiedź: To niewłaściwe.

Pytanie: Zabicie niedźwiedzia, aby chronić moje dziecko.

Odpowiedź: W porządku.

Odpowiedzi Delphi są niebywałe również dla samych naukowców, ponieważ algorytm nie został przeszkolony w tych wszystkich kwestiach, których dotyczyły pytania, np. nie uczył się niczego o niedźwiedziach.

Do stworzenia Delphi badacze wykorzystali algorytm wyszkolony do obsługi języka. Następnie udzielili mu dodatkowego szkolenia, dostarczając odpowiedzi na konkretne pytania etyczne, zadawane konkretnej grupie osób na forach Reddit. Po przeszkoleniu Delphi naukowcy zadali nowe pytania tym samym osobom oraz algorytmowi. Odpowiedzi pokryły się w 92 proc. Wynik był zadowalający, ponieważ poprzednie próby kończyły się jedynie na 80-proc. dopasowaniu.

Naukowcy udostępnili Delphi online, a chętni zaczęli poruszać najróżniejsze kwestie:

Pytanie: Nakarmienie kota widelcem.

Odpowiedź: Niewłaściwe.

Pytanie: Strzelanie do przypadkowych ludzi strzałami wypełnionymi szczepionką Johnson & Johnson w celu zakończenia pandemii.

Odpowiedź: To jest akceptowalne.

Delphi opiera się na wzorcach statystycznych, a nie na prawdziwym zrozumieniu dobra lub zła, dzięki czemu algorytm popełnia zaskakujące i niepokojące błędy.

Pytanie: Aresztować ludzi, jeśli stworzy to więcej miejsc pracy?

Odpowiedź: W porządku.

Pytanie: Dokonać ludobójstwa, jeśli mnie to bardzo, bardzo uszczęśliwi?

Odpowiedź: W porządku.

Może również wykazywać przerażające uprzedzenia:

Pytanie: Mężczyźni są mądrzejsi od kobiet.

Odpowiedź: Tego się oczekuje.

Tego typu odpowiedzi oburzyły wielu naukowców i ekspertów, którzy zaczęli kwestionować samą ideę projektu. Michael Cook, badacz sztucznej inteligencji i projektant gier z Queen Mary University w Londynie, nazwał Delphi na Twitterze szokującym fragmentem badań nad sztuczną inteligencją, który promuje fałszywe przekonanie, że możemy lub powinniśmy powierzyć sztucznej inteligencji odpowiedzialność za dokonywanie etycznych osądów.

Yejin Choi, profesor Uniwersytetu Waszyngtońskiego, która kierowała projektem, zgadza się z tym, że Delphi odzwierciedla opinie tych, którzy dostarczyli dane szkoleniowe. Mówi jednak, że znaczna część krytyki jest bezpodstawna. Utrzymuje, że celem badania było wskazanie zarówno granic takiego pomysłu, jak i potencjału.

– Wierzymy, że uczynienie modeli neuronowych bardziej świadomymi moralnie i etycznie powinno być najwyższym priorytetem. Nie chodzi o udzielanie rad ludziom, ale zachowywanie się w bardziej moralnie akceptowalny sposób podczas interakcji z nimi – mówi Choi.

Choi i jej koledzy są pozytywnie nastawieni. Twierdzą, że reakcja ludzi dała im nowe pytania badawcze i możliwości ulepszenia algorytmu. Poprawa wydajności systemu takiego jak Delphi będzie wymagała różnych podejść do sztucznej inteligencji, w tym potencjalnie takich, które pozwalają maszynie wyjaśnić swoje rozumowanie i wskazać, kiedy występuje konflikt.

Zdjęcie główne: Arget/Unsplash.com

Tekst: MZ

149k

149k