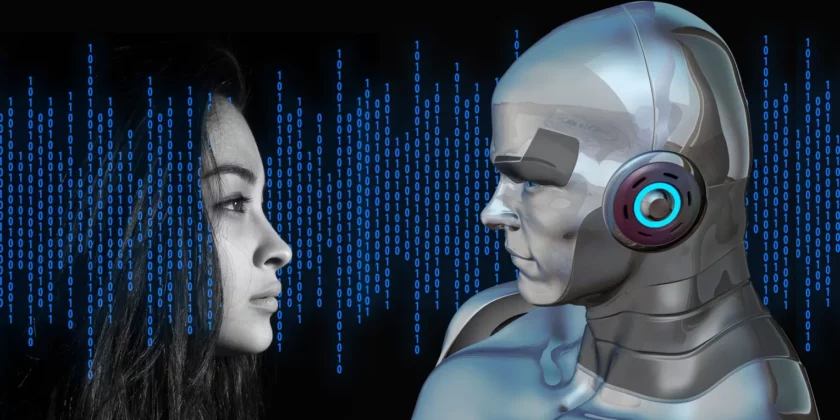

Czy sztuczna inteligencja może nauczyć się moralności?

Sztuczna inteligencja jest konstruktem społecznym, podobnie zresztą jak moralność. Test Turinga, który jest najsłynniejszym testem mierzącym stopień zaawansowania sztucznej inteligencji, polega na tym, że to ludzie oceniają, czy coś można za nią uznać, czy też nie (a nie wynika to bezpośrednio z jakichś wewnętrznych właściwości danego systemu). Z kolei moralność jest owocem wzajemnych społecznych ustaleń i interpretacji, które wypływają z wielu źródeł (są nimi np. różne święte księgi).

Strach przed SI i grząski grunt moralności

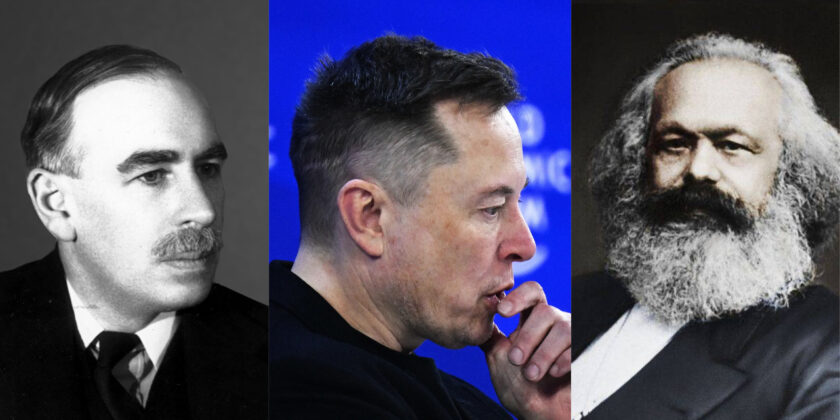

Obawy dotyczące rozwoju sztucznej inteligencji w dużej mierze odnoszą się do wizji, w których przejmuje ona kontrolę nad swoimi twórcami, czyli ludźmi. Podstawę do nich dał m.in. znany amerykański futurolog Ray Kurzweil, który stwierdził, że do 2029 roku inteligentne maszyny osiągną zdolność do przechytrzenia człowieka. Stephen Hawking, którego nikomu nie trzeba przedstawiać, nakreślił scenariusz, w którym ukształtowana sztuczna inteligencja usamodzielni się i będzie się przeprojektowywać w niezwykle szybkim tempie. Twórca Tesli Elon Musk mówi wprost, że rozwój inteligentnych systemów stanowi „podstawowe zagrożenie dla istnienia ludzkiej cywilizacji”.

Przedmiotem dyskusji są zatem konsekwencje wprowadzania sztucznej inteligencji do kolejnych obszarów życia i zagrożenia wynikające z jej ewentualnego usamodzielnienia się. Największe wątpliwości etyczne dotyczą ludzkich decyzji, czy w pewnych sferach aplikować SI czy nie.

Coraz wyraźniej jednak zaznaczana jest kwestia etyczności samej SI, tego, czy i w jakim stopniu jest w stanie nauczyć się ludzkiego systemu norm oraz wartości. Z co najmniej kilku powodów jest to bardzo grząski grunt.

Po pierwsze, moralność nie jest dziedziną trwałego konsensusu, ale ciągłych dyskusji, a nawet sporów. Skoro ludzie nie mogą obrać wspólnego stanowiska w sprawie wielu problemów etycznych, to nie trzeba wspominać, jak sytuacja komplikuje się w przypadku aplikowania scenariuszy moralnego postępowania do SI.

Kolejną sprawą jest zmienność systemów normatywnych w czasie. Vincent Conitzer, profesor informatyki z Uniwersytetu Duke’a zauważa, że gdyby postawić ludzi żyjących sto lat temu przed dylematami moralnymi, które zaprzątają nasze sumienia i umysły obecnie, to można byłoby się spodziewać np. podejścia zdecydowanie bardziej rasistowskiego czy seksistowskiego. Z kolei za sto lat nasi następcy mogą być w moralnym szoku, chociażby w odniesieniu do tego, jak traktowaliśmy zwierzęta. Ewolucja ludzkiej moralności stanowi spore wyzwanie dla długofalowego programowania sztucznej inteligencji.

Problem tkwi nie tylko w opracowaniu treści scenariuszy, ale także w nadaniu im obiektywnej i mierzalnej formy, aby mogły zostać przetworzone przez mechanizmy SI. Conitzer podkreśla, że trzeba uwzględnić mnóstwo czynników, jak podział sfer na prywatną i publiczną, różne role społeczne, zdarzenia z przeszłości (np. obietnice) czy motywy i intencje.

Moralność jest systemem bardzo złożonym. Dość łatwo można zaaplikować altruizm do wykorzystywanej przy projektowaniu SI teorii gier, ale wszystko komplikuje się, kiedy jest on „zanieczyszczony” np. przez poczucie długu wdzięczności, który oprócz racjonalnej kalkulacji zawiera w sobie duży bagaż emocjonalny.

Nie bez znaczenia jest także fakt, że niezwykle trudno jest odseparować wartości od języka, tj. posługiwać się wyłącznie moralnie neutralnymi słownictwem. A używanie go w stosunku do kwestii moralnych wydaje się już zupełnie niemożliwe. Stwarza to podstawową trudność w bezstronnym, pozbawionym nieuświadomionych uprzedzeń programowaniu językowych modeli SI.

Programowanie dobra

Badacze SI są jednak zdania, że uda się pokonać wspomniane przeszkody i stworzyć wprawdzie nie idealną, ale całkiem użyteczną umiejętność moralnego postępowania przez zautomatyzowane systemy, która sprowadzałaby się do podejmowania przez nie decyzji, które w danej sytuacji będą powodować więcej dobra niż zła.

Chodzi o sytuacje, które w niedługim czasie staną się naszą codziennością. Jako przykład można podać autonomiczne samochody, które w niektórych zdarzeniach na drodze będą zmuszone podejmować bardzo trudne decyzje ciążące w kierunku oszacowywania wartości ludzkiego życia. Bardziej skomplikowane systemy SI znajdą zastosowanie m.in. jako asystenci edukacyjni. Ich kompas moralny będzie miał spory wpływ na rozwój dziecięcych postaw oraz przekonań. Dlatego tak ważne jest jego odpowiednie nastawienie.

Jak według specjalistów od SI i etyki można tego dokonać?

Punktem wyjścia jest wyraźne zdefiniowanie, jakie zachowania w danych warunkach będą etyczne, a jakie nie. Wartości i normy moralne muszą zostać sformułowane jako mierzalne parametry. W ten sposób trzeba zbudować scenariusze, które inteligentne maszyny wykorzystają do rozwiązania napotkanych dylematów moralnych.

Aby do tego doszło, musimy między sobą uzgodnić najbardziej etyczne sposoby postępowania w danych sytuacjach – wyzwanie niezwykle trudne, ale jak podkreślają eksperci, nie niemożliwe. Niemiecka komisja etyczna zajmująca się zautomatyzowanymi pojazdami zaleciła specjalnie zaprogramowanie wartości w samochodach samojezdnych, aby ponad wszystko priorytetem była ochrona życia ludzkiego. Podstawowy warunek, jaki postawiono, dotyczy tego, że konkretne ludzkie życia nie powinny podlegać kwalifikowaniu – samochód nie może być w stanie decydować, jeżeli powstanie taki dylemat, którą osobę potrącić, na podstawie indywidualnych cech takich jak płeć, wiek czy kolor skóry.

Pozyskiwanie informacji do scenariuszy, które staną się inputem moralnych systemów SI może się odbywać na zasadzie crowdsourcingu. Moralny trening maszyn wymaga dostarczenia im ujednoliconych danych w wielu wariantach. Można to robić, pozyskując je od milionów ludzi, którzy będą rozwiązywać przedstawione im dylematy moralne. Realizacją tej koncepcji jest Moral Machine MIT, która informacje wykorzystywane do programowania samojezdnych samochodów pozyskuje właśnie z testów rozwiązywanych przez ochotników.

W końcu należy zadbać o dostateczną przejrzystość inteligentnych algorytmów. Nie chodzi tutaj o mechanizm ich działania, który jest na tyle skomplikowany i złożony, że pełna jego kontrola przez inspektorów społecznych jest od strony technicznej w zasadzie niewykonalna.

Żądanie transparentności tyczyć się winno sposobów kwantyfikowania wartości etycznych przed ich zaprogramowaniem, a także wyników działań SI na ich postawie, które powinny być skrupulatnie magazynowane. Wszystko to, dlatego że automatyzacja nie zdejmuje z nas odpowiedzialności za jej niepożądane efekty.

Jeżeli nie będziemy starać się odkrywać wzorów w naszych moralnych wyborach i przekładać ich na systemy SI, to skutki takiego zaniechania mogą doprowadzić do tego, że to algorytmy zaczną decydować o tym, co jest dla nas dobre, a więc de facto przejmą nad nami cichą i trwałą kontrolę.

Zdjęcie główne: Unplash.com

Tekst: Paweł Konar