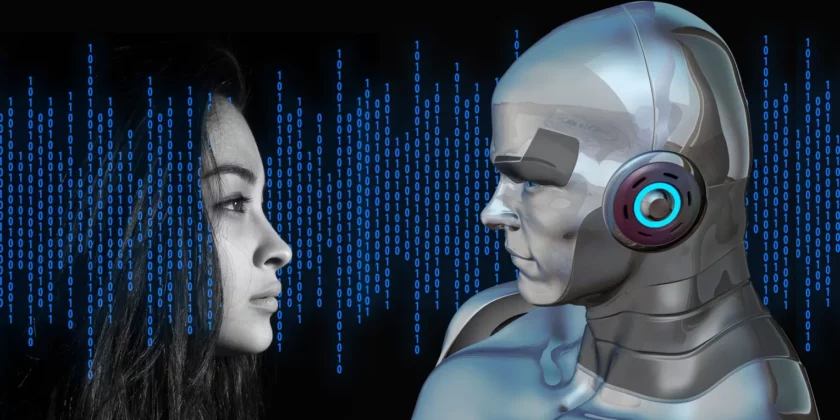

AI pomaga w 'oszustwie na wnuczka’. Wygenerowany przez oszustów głos może brzmieć jak nasi bliscy

Do 73-letniej Ruth Card zadzwoniła osoba, która brzmiała całkiem jak jej wnuk Brandon. To nie były dobre informacje: Brandon powiedział, że jest w areszcie, nie ma ze sobą ani portfela, ani telefonu i potrzebuje pieniędzy na kaucję. Ruth postanowiła działać natychmiast. Wraz z mężem od razu pobiegli do banku, skąd wypłacili 3 tys. dolarów kanadyjskich (ponad 9,6 tys. zł), czyli dzienne maksimum. Stamtąd skierowali się do kolejnego oddziału, by wyciągnąć więcej pieniędzy. Wtedy zainterweniował kierownik banku. Zabrał ich do biura i powiedział, że inny klient też niedawno otrzymał podobny telefon i okazało się, że to oszustwo. Tak było i w tym przypadku. Głos Brandona został wygenerowany komputerowo. Deepfake’i stają się coraz popularniejszą metodą oszustw telefonicznych.

Oszuści od dawna podają się za członków rodziny, by wyciągać pieniądze od swoich ofiar. Teraz może im to jednak iść znacznie łatwiej. Postępy związane ze sztuczną inteligencją pozwalają na coraz szybsze i łatwiejsze wygenerowanie dowolnego głosu. Potrzebna jest tylko kilkuzdaniowa próbka dźwiękowa 'oryginału’. W internecie dostępne jest wiele tanich narzędzi, dzięki którym wygenerowany głos powie, co tylko zechcemy. – Dwa lata temu, a nawet jeszcze przed rokiem, potrzebna była duża próbka dźwięku, aby sklonować czyjś głos. Dziś, jeśli […] nagrałeś 30-sekundowego TikToka, w którym pojawia się twój głos, to wystarczy, by go sklonować – mówi Hany Farid, profesor kryminalistyki cyfrowej na Uniwersytecie Kalifornijskim w Berkeley.

Zwykle próbkę głosu z łatwością można znaleźć w sieci – nie tylko na TikToku, ale też na YouTubie, Instagramie, Facebooku czy w podcastach.

A oprogramowanie, jak ElevenLabs, może być darmowe albo kosztować od 5 do 330 dolarów miesięcznie – im droższe, tym dłuższą próbkę dźwięku wygeneruje. ElevenLabs doczekało się już zresztą krytyki, gdy internet zaczęły zalewać głosowe fałszywki z udziałem celebrytów – na jednej z nich Emma Watson czytała 'Mein Kampf’. Firma ogłosiła wówczas, że wprowadza zabezpieczenia zapobiegające nadużyciom, w tym zakaz tworzenia 'niestandardowych’ głosów przez darmowych użytkowników i uruchamia narzędzie do wykrywania dźwięku generowanego przez sztuczną inteligencję. Tylko że to narzędzie nie pomoże raczej takim osobom jak Ruth Card. Emocje, które pojawiają się, gdy słyszą one, że ich bliski jest w niebezpieczeństwie, grają tu znaczącą rolę. A poza tym, kiedy mówi to znajomy głos, naprawdę trudno podejrzewać, że coś jest nie tak. Niemniej warto mieć się na baczności, bo oszustwo 'na wnuczka’ stało się właśnie dużo trudniejsze do namierzenia.

Tekst: NS